به دنبال راهی برای بهینه سازی Robots.txt برای SEO در وب سایت وردپرس خود هستید؟ در این مقاله، ما شما را برای بهینه سازی Robot.txt برای بهبود سئوی وب سایت وردپرس خود راهنمایی می کنیم.

فایل Robots.txt بسیار مهم است که به موتور جستجو در خزیدن وب سایت شما کمک می کند. به شما کمک می کند سئوی سایت خود را بهبود بخشید. اگر بتوانید فایل Robots.txt را به درستی بهینه کنید، به راحتی می توانید موقعیت بالاتری در موتورهای جستجو کسب کنید. اما قبل از بهینه سازی آن، باید بدانید فایل Robots.txt چیست و چگونه کار می کند؟

فایل Robots.txt چیست؟

فایل Robots.txt فایلی است که به موتور جستجو میگوید صفحات وبسایت را فهرست یا خزیده کند. به طور پیش فرض، فایل در پوشه اصلی یا پوشه اصلی وب سایت شما قرار دارد. یک فایل Robots.txt باید شبیه این باشد.

User-agent: [user-agent name]

Disallow: [URL string not to be crawled]

User-agent: [user-agent name]

Allow: [URL string to be crawled]

Sitemap: [URL of your XML Sitemap]

میتوانید چندین URL را در فایل Robot.txt خود اضافه کنید تا به هر URL خاصی اجازه دهید در موتور جستجو نمایه شود. همچنین در صورت تمایل میتوانید چندین نقشه سایت اضافه کنید.

چرا برای سئو به Robots.txt نیاز دارید؟

موتورهای جستجو بدون فایل Robots.txt همچنان وب سایت شما را ایندکس می کنند و می خزند، اما شما هیچ کنترلی بر عدم اجازه دادن به صفحه خاصی برای فهرست بندی ندارید. اگر به تازگی وب سایت خود را راه اندازی کرده اید و محتوای کمتری دارید، این هیچ تاثیری نخواهد داشت. شما می توانید وب سایت خود را بدون داشتن فایل Robots.txt اجرا کنید.

اما روز به روز وب سایت شما رشد می کند و محتوای زیادی خواهید داشت، پس باید کنترل بیشتری روی فهرست بندی موتورهای جستجو داشته باشید. موتورهای جستجو برای هر وب سایت یک سهمیه نمایه سازی دارند. همه صفحات وب سایت شما نیازی به خزیدن در موتورهای جستجو مانند صفحات مدیریت، صفحات فایل ها و موارد دیگر ندارند. بنابراین اگر آن را کنترل نکنید، صفحات مهم شما فرصتی برای فهرست بندی در موتورهای جستجو نخواهند داشت.

جلوگیری از خزیدن صفحات غیر ضروری به شما کمک می کند تا صفحات مهم تر وب سایت خود را ایندکس کنید.

چگونه یک فایل Robots.txt ایجاد کنیم ؟

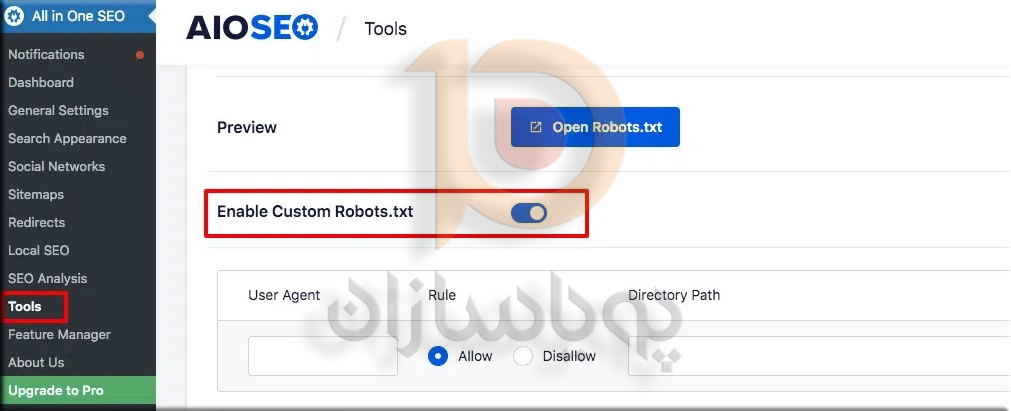

راه های مختلفی برای ایجاد فایل Robots.txt وجود دارد. استفاده از افزونه ساده ترین و سریع ترین راه برای ایجاد فایل Robots.txt است. افزونه All in One SEO وردپرس راهی آسان برای ایجاد یک فایل Robots.txt به شما ارائه می دهد. افزونه را نصب و فعال کنید و سپس به All in One SEO > Tools بروید که در آنجا فایل Robots.txt پیش فرض را پیدا خواهید کرد. ابتدا باید گزینه Enable Custom Robots.txt را فعال کنید.

می توانید فایل Robots.txt پیش فرض را با استفاده از دکمه پیش نمایش مشاهده کنید. فایل پیشفرض Robots.txt به موتور جستجو میگوید که فایل یا دایرکتوری اصلی وردپرس شما را نخزد. اکنون می توانید قوانین سفارشی خود را اضافه کنید. برای افزودن نقش جدید، عامل کاربر را اضافه کنید، آن را مجاز یا غیرمجاز کنید و در آخر URL را وارد کنید. بر روی Add rule کلیک کنید.

این قانون به طور خودکار به فایل Robots.txt اضافه می شود. دوباره همین روند را دنبال کنید تا قانون دیگری اضافه کنید.

Robots.txt را برای سئو تست کنید

می توانید فایل Robots.txt خود را با استفاده از ابزارهای کنسول جستجوی گوگل آزمایش کنید.

به صفحه ابزار تست ربات کنسول جستجوی گوگل وب سایت متصل خود بروید و ویژگی را انتخاب کنید. اخطار و خطای فایل Robots.txt را به شما نشان می دهد.